대한민국에서 데이터 과학의 많은 기술들은 더 이상 새로움과 신선함을 주는 분야는 아니다.

관련 분야를 종사하지 않고, 전공하지 않았더라도 한번쯤은 머신러닝이나 딥러닝(또는 알파고)이라는 단어를 접해봤고, 인공지능이라는 단어는 더욱 친숙하다. 설령 그것이 정확히 어떻게 구현되어 무슨 기능을 하는지는 몰라도 말이다. 그만큼 사회적인 붐이 일고 있다는 것이다.

전세계적으로 기술 트렌드를 이끌고 있는 분야 중 하나인 데이터 과학에 대해서 많은 이들의 관심과 이목이 집중된다는 것은 물론, 명과 암이 있겠지만 대체로 반가운 현상이라고 볼 수 있겠다.

데이터 과학은 실제로는 굉장히 폭이 넓고 깊이가 깊은 분야를 총칭한다. 그래서 그것이 무엇이며 어떠한 과정으로 이루어지는지를 애둘러 말하기는 다소 무리가 있지만 그래도 어느 정도 일반화된 방법론들이 있다. 그 중에서 데이터를 모으는 행위, 흔히 데이터 수집이라고 일컫는 과정은 그 모든 파생분야의 공통분모와도 같은 초기 접근 단계이다. 모아져 있는 데이터를 이용하여 진행하는 프로젝트라고 하더라도 데이터의 추가적인 수집은 발생할 수밖에 없는 절차인데 하물며 직접 문제를 정의하고 시작하는 프로젝트라면 데이터의 수집은 어떤 건축물을 세우기 위한 공사에서 지반을 다지는 것만큼의 중요한 첫 공정이다.

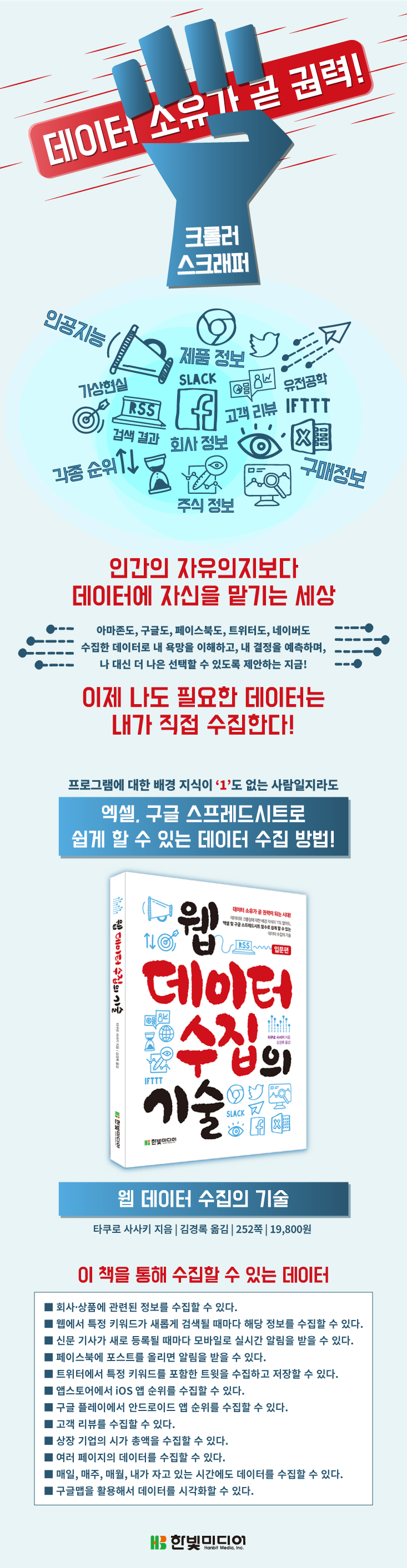

'웹 데이터 수집의 기술 (지은이 : 타쿠로 사사키, 옮긴이 : 김경록, 펴낸곳 : 한빛미디어㈜'은 웹에서의 수 많은 데이터를 수집하는 과정을 우리에게 너무도 친숙한 도구들(마이크로소프트 엑셀, 구글 스프레드시트 등)을 이용하여 설명한다.

지은이의 글을 통해 타쿠로 사사키 작가는 누구나 쉽게 배우고 쉽게 따라할 수 있게 하기 위해 이 책을 집필했음을 강조하고 있다. 그래서 이 책은 웹, 스크래핑과 크롤링, 프로그래밍 언어에 대한 깊은 지식이 없어도 엑셀과 같은 스프레드 시트 프로그램을 써본 사용자라면 쉽게 개념을 잡고 따라해볼 수 있다. 즉, 웹 데이터를 수집해 볼 수 있다.

총 6개의 챕터로 구성되어 있다.

Chapter 1. 웹 데이터를 수집하기 위해 알아야 하는 것들

Chapter 2. 엑셀을 이용한 웹 데이터 수집의 기술

Chapter 3. 구글 스프레드시트를 이용한 웹 데이터 수집의 기술

Chapter 4. 스크래핑 전용 서비스를 이용하여 웹에서 데이터 수집하기

Chapter 5. 앱을 이용하여 페이스북에서 데이터 수집하기

Chapter 6. 다양한 데이터 수집하기

각 챕터의 면면을 살펴보면 친숙한 프로그램들이 곳곳에 포진되어 있다. 필자가 학부에서 상경계열을 전공하고, 컴퓨터는 학습과 업무용으로 사용하며 프로그래밍 언어는 접해본 경험이 거의 없는 수준임에도 그렇다. 이 것이 이 책의 가장 큰 장점이라고 생각된다. 익숙한 도구를 이용한다는 것은 큰 장점이다. 매일 먹던 음식도 다른 나에게 익숙한 수저가 아닌 생소한 도구로 먹으려면 힘들고 어렵다. 짜증난다. 그런데 생소한 음식도 나에게 익숙한 수저로 먹기 시작한다면 그 음식의 맛이 있고 없고를 떠나서 이질감이 감소한다. 조금 더 내 앞에 놓여진 음식에만 집중할 수 있다.

쉬운 마음으로 접할 수 있다 보니 유의해야 할 것이 있다. 눈으로 보는 책이 아니다. 손으로 보는 책이다.

반드시 책에서 알려주는 순서대로 차분하게 따라해 보아야 한다. 한 쪽당 글자 수는 적고 실제 프로그램의 캡처 사진이 많다. 그러다보니 눈으로만 책을 보게 되면 책장이 술술 넘어간다. 그리고 마지막 책장을 덮을 때쯤에는 머리속에는 남는 것이 없을 것이다. 그러니 가급적이면 이동수단에서 읽기 보다는 컴퓨터가 있는 곳에서 책을 보면서 천천히 따라해보기를 권한다.

재미있는 겉핥기

아마도 이 책의 지은이의 가장 큰 고민은 '어디까지 설명해야 하는가'가 아니었을까 싶다.

마음먹고 깊이 파고들면 끝도 없이 깊어질 분야들을 엮었기 때문이다.

이 책을 읽고 나서 "웹 데이터 수집"이라는 꽤나 유용한 기술을 익숙한 몇 가지 도구를 통해서 직접 해보면서 재미 또는 흥미를 느끼고, 본인의 판단에 적합한 도구로 책에 소개되지 않은 웹 데이터 수집을 해보면서 공부를 이어나가게 된다면 이 책의 값어치는 충분히 해냈다고 생각된다.

처음 가보는 뷔페 음식점에서 종류별로 한두개씩 맛보면서 빠르게 한바퀴를 돈다고 생각해도 좋을 것 같다. 무슨 줄인지도 모른채 어떤 코너의 줄에 서고 십여분을 서있다가 맛도 없고 질기기만한 고기 한덩어리를 받아오는 우를 범하기 전에 우선은 전체를 빠르게 탐색, 관찰해 보는 것이다.

읽으시는 분들도 예상하겠지만 이 책에 소개된 내용만으로 모든 웹 데이터를 수집할 수 없다.

이 책에 소개된 쉽고 빠른 방법들도 그 원리를 이해하기 위한 모든 설명을 하지는 않았다. 그랬다가는 이 책의 핵심 집필의도를 어기고 어려워지기 때문일 것이다.

천리 여행길을 떠나기 위해서 전체 여행코스를 슬쩍 볼 수 있고 첫 발을 내딛기 위한 방향을 소개한다고 생각하고 편안하게 첫 페이지를 열어보자. 그리고 조금씩 조금씩 데이터를 모아보자. 시작이 반이다.